Vers l'image augmentée

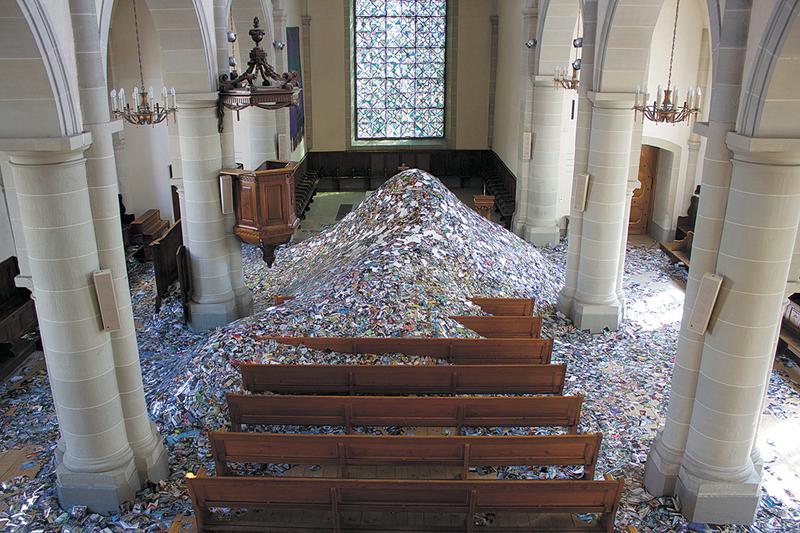

La photographie tend à exister en masse. Dès la deuxième moitié du XIXe siècle, d’importants développements technologiques ont concouru à augmenter la production et la mise en circulation des photographies, de la bobine de film à la carte mémoire, des appareils de petit format aux capteurs numériques, en passant par la chronophotographie, le bélinographe ou le microfilm (fig. 1). Cette tendance à la production massive d’images techniques fut source d’anxiété pour de nombreux commentateurs, à l’instar de Charles Baudelaire dénonçant une « invasion de la photographie1 » alors que l’apparition du procédé au collodion humide ouvrait la voie à une plus ample exploitation du médium2. Depuis, une telle critique n’a cessé de réapparaître avec une remarquable régularité. L’essor de l’impression rotative dans l’entre-deux-guerres conduisit, par exemple, le sociologue allemand Siegfried Kracauer à comparer l’abondance croissante d’illustrations dans la presse à une « marée d’images [Bilder-flut]3 » menaçant de tout balayer sur son passage. Plus récemment, la multiplication de photographies numériques sur les plateformes de partage a été associée à des « bombardements visuels » face auxquels il serait impossible de se dresser sans être « emporté par le flux des photographies »4.

Infrastructures

Dans un essai paru en 1928, l’écrivain et philosophe français Paul Valéry imaginait une « Société pour la distribution de la réalité sensible » fournissant à ses clients un accès à domicile à toutes formes d’expériences sensorielles, visuelles ou sonores : « Comme l’eau, comme le gaz, comme le courant électrique viennent de loin dans nos demeures répondre à nos besoins moyennant un effort quasi nul, ainsi serons-nous alimentés d’images visuelles ou auditives, naissant et s’évanouissant au moindre geste, presque à un signe12 ». Cette analogie trouva un écho jusque chez les professionnels des institutions patrimoniales. En 1950, par exemple, Paul Vanderbilt, alors conservateur du nouveau département des Estampes et de la photographie de la Library of Congress, plaidait pour une amélioration des infrastructures donnant accès aux connaissances véhiculées par l’image, les présentant comme un « service public [utility] » comparable dans son étendue et sa complexité au réseau hydraulique13. Comme Valéry, Vanderbilt associait la consommation d’images aux gestes quotidiens garantissant l’approvisionnement aisé en ressources primaires. Or, de la même façon que le plus simple de ces gestes – tourner un robinet, appuyer sur un interrupteur – ne saurait cacher l’extraordinaire complexité des infrastructures qui, de la source à nos maisons, transforment des éléments naturels en ressources exploitables et couramment accessibles, le regard que nous portons aujourd’hui sur une image affichée à l’écran peut être tributaire d’un effort équivalent d’extraction, de traitement et de distribution. Plus discrets que les installations d’acier et de béton dévolues au contrôle des flux hydrauliques ou gaziers, les systèmes d’information spécialement conçus à cet effet n’en ont pas moins mobilisé un ensemble de pratiques, d’équipements et de ressources dépassant largement le seul cadre de la prise de vue et celui de l’utilisateur regardant et commentant une photographie affichée sous ses yeux14. Entre ces deux extrêmes, c’est un réseau complexe d’infrastructures et d’intermédiaires que cette première partie du dossier invite à explorer.Dans l’article d’ouverture, Jonathan Dentler (pp. 14-25) souligne l’importance de l’appareil logistique employé par la presse de l’entre-deux-guerres pour la télétransmission d’images fixes par câble ou par radio. Alors que la transformation d’une photographie en impulsions électriques instantanément transmises à travers l’Atlantique impliquait une forte compression et une dégradation de l’image, cette altération même permit aux journaux qui y avaient recours d’attester par la granulosité de la reproduction sa nature d’image télétransmise. Elle donnait ainsi une forme à la réduction rapide des distances que les réseaux de télécommunication rendaient alors possibles. Bruit indésirable du point de vue des sciences de la communication, les traces de la transmission se firent indices visibles de l’accélération des liaisons transnationales, érigeant les « images câblées » en « icônes de la vitesse », symboles d’une culture globalisée en plein essor.

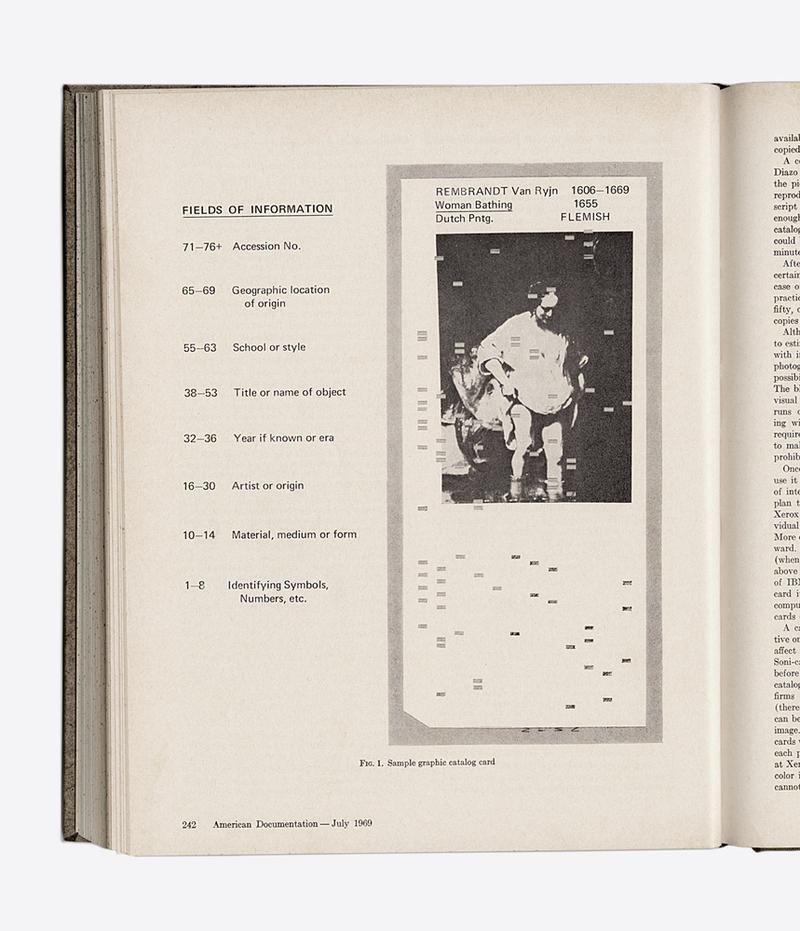

Ingénieurs, bibliothécaires, informaticiens, mais aussi représentants d’autres métiers dont on tend aujourd’hui à perdre la trace, notamment les iconographes ou les opérateurs télégraphistes, développèrent un ensemble de connaissances propres au traitement des images, toutes fondées sur de nouvelles interactions entre la photographie et d’autres techniques de communication, de la machine à écrire à la carte perforée en passant par le téléphone ou le phonographe (fig. 3). Cet aspect est souligné dans l’étude de Peter Sachs Collopy (pp. 26-35), qui rappelle que l’un des tournants décisifs de l’histoire de la photographie s’est opéré lors du remplacement de la photochimie par des supports électromagnétiques au moment de l’émergence des premiers appareils « électroniques analogiques ». Il met en lumière la façon dont la bande magnétique devint un support pour tout type de signal électronique – son, image, texte, chiffres –, établissant une continuité inédite entre des éléments qui avaient jusqu’alors été attachés à des supports aux propriétés physiques distinctes.

En somme – et c’est là l’hypothèse principale introduite dans la première partie de notre dossier –, envisager la photographie du point de vue de la quantité et de la circulation massive des images revient à la considérer avant que les regards ne se portent sur elle, et parfois même indépendamment d’eux. De l’annotation à la miniaturisation, de la transmission par ondes radio à l’analyse par algorithme, la photographie se donne moins comme une image autonome destinée à notre seule vision que comme un élément constitutif d’un système plus large et multimédial. À la fois dispositif de transmission et donnée transmise, outil de traitement aussi bien qu’objet traité, la photographie entretient avec les technologies de l’information une relation duelle, au cœur de la suite du dossier.</p>

Le présent dossier propose d’envisager les liens de la photographie aux techniques de l’information moins comme une spécificité de l’ère numérique que comme un aspect ayant ponctué, fût-ce de façon discrète et non linéaire, toute l’histoire du médium. Cette approche tend à dévoiler la photographie sous un jour bien moins uniforme qu’attendu. Faire une archéologie des usages informationnels du médium appelle en effet à dépasser les discours sur la fonction indexicale et le statut de preuve dans lesquels on a souvent voulu inscrire l’image technique. Ni pur objet de contemplation, ni simple renseignement factuel pour autant, la photographie a entretenu avec les technologies de l’information un rapport ambigu et fragile. Cela s’en ressent jusque dans la terminologie : dès lors que le regard porté sur une image se trouve prolongé par les opérations de lecture et de décodage, est-il possible de tracer une distinction nette entre information et donnée ? Et où situer la limite entre signal utile et « bruit » indésirable, là où quantité de clichés révéleront après coup seulement une richesse d’informations imprévue par le photographe8 ? Pour affronter toute la complexité de la place occupée par la photographie au sein de la société de l’information, nous avons voulu ouvrir le champ de l’histoire de la photographie à d’autres approches, de l’histoire des médias aux sciences de l’information, de l’histoire de l’ethnologie à celle de l’architecture.

C’est principalement à la suite de ce qu’on a voulu appeler le « tournant numérique » que l’histoire longtemps marginalisée des pratiques liées à la production, au traitement et à l’échange de grandes quantités d’images a attiré l’attention des chercheuses et des chercheurs, désireux de mettre en lumière les usages sociaux, les infrastructures et les enjeux institutionnels de la production photographique en dehors du champ restreint de l’esthétique et de l’analyse formelle de l’image. À la suite du numéro inaugural de Transbordeur consacré à l’impact de la profusion des images sur les institutions patrimoniales et plus spécifiquement à l’apparition, au tournant du XXe siècle, de ce que l’on appelait alors les « musées de photographies documentaires9 », ce dossier propose de prolonger la réflexion par le biais d’études portant sur des cas plus récents, de l’entre-deux-guerres à nos jours. Il est le résultat d’échanges entamés lors du colloque « Photographie et technologies de l’information », organisé en novembre 2017 à l’université de Lausanne10. À son origine se trouvent deux projets de recherche menés à Lausanne, « Toute la culture du monde sur pellicule. Essor et imaginaire du microfilm des années 1920 aux années 1950 » et « Au seuil du numérique. Microformes et systèmes automatisés de recherche des images des années 1950 aux années 1980 ». Ces deux projets explorent l’histoire de la microphotographie, terme générique pour toute forme de reproduction de documents sur support photochimique souple, dont le rôle s’avère essentiel pour saisir la préhistoire des humanités numériques et, plus généralement, de la culture numérique. Elle émerge alors comme l’une des techniques pionnières de l’information à travers laquelle s’est jouée une partie essentielle de la transition entre la matérialité du papier et la supposée immatérialité du numérique, faisant du microfilm le « chaînon manquant » entre l’ère du livre et la société de l’information actuelle11.

Dispositifs

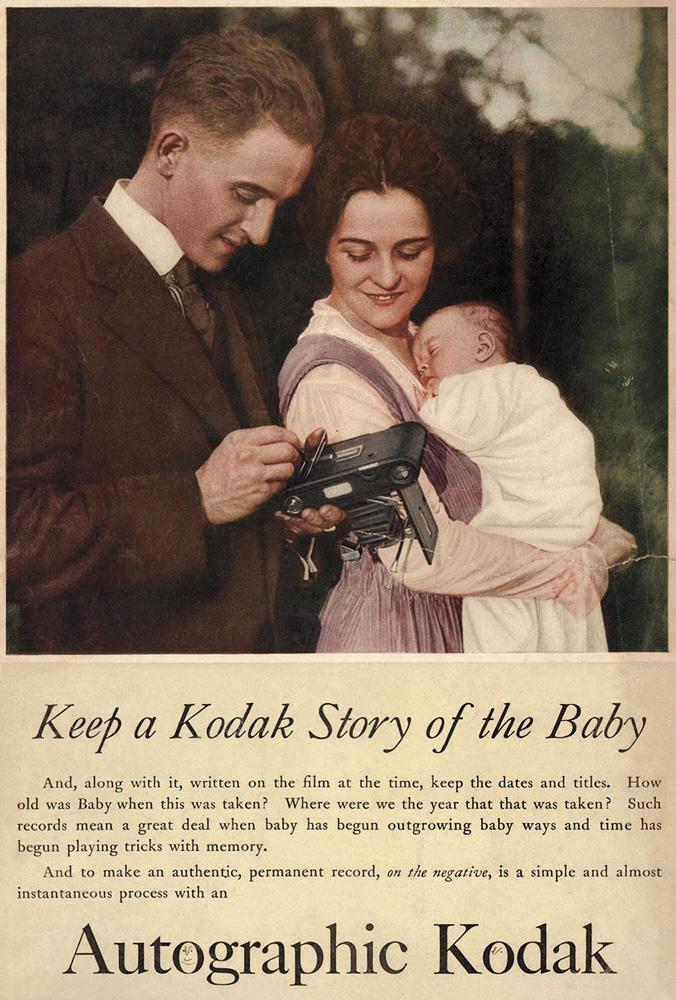

On l’a dit, l’histoire de la photographie est marquée par le grand nombre. Dans le mouvement d’accélération et d’automatisation de la production et de la diffusion des images, l’appareil photographique a été progressivement amené à dépasser l’opération élémentaire d’enregistrement mimétique du monde pour devenir un médium hybride englobant à la fois l’enregistrement visuel et le traitement des données qui lui sont relatives. Son statut s’en est trouvé profondément redéfini : de surface servant de support matériel à l’image latente, la photographie est devenue une interface à travers laquelle cette même image se trouvait non seulement fixée, mais encore augmentée de toutes sortes de renseignements – chronologiques, géographiques, techniques, descriptifs – qui lui permettaient de se donner à voir (et à lire) comme information.Il va aujourd’hui de soi que les appareils photographiques sont destinés à générer non seulement des images, mais aussi des informations permettant de les propulser ensuite dans un réseau plus large à l’aide d’infrastructures interconnectées. Ce paradigme informationnel, non réductible au numérique, est cependant le fruit d’une histoire plus longue, précédant considérablement le développement des premiers capteurs électroniques. Sans surprise, c’est le champ de la photographie amateur qui, après avoir contribué à l’explosion de la production15, incita à développer des moyens d’annoter les images pour faire face à la masse. En septembre 1914, le fabricant américain Eastman Kodak lança ainsi l’Autographic Kodak, accessoire situé au dos de l’appareil et couplé à un type nouveau de pellicule permettant d’associer aux prises de vue « les indispensables qui-quand-où » directement sur la surface du négatif sous la forme d’« annotations auto-photo-graphiques [auto-photo-graphic records] » (fig. 4).

Si son emploi effectif est difficile à quantifier, l’Autographic Kodak marqua bien un point de bascule en ce qu’il introduisit une idée de l’appareil photographique comme machine modulable capable d’additionner des fonctions médiales différentes : avec l’écriture et la prise de vue, il fit converger deux flux distincts de données – manuscrits et optiques – sur une même unité de stockage. Ce principe de modularité fut dès lors au cœur de nombreuses techniques de l’information développées dans le but de rassembler, traiter et donner accès à de vastes quantités de documents textuels et visuels. C’est notamment le cas de la microphotographie, dont Michael Faciejew (pp. 48-61) examine l’impact sur l’essor des notions mêmes d’« information » et de « technologie de l’information » dans la sphère publique, et plus particulièrement sur les travaux de modernisation de la Bibliothèque nationale de France dans les années 1930. Support « universel » capable de réunir sous une forme homogène des sources très diverses, le microfilm suscita à l’époque l’espoir d’une diffusion améliorée des connaissances, dont les effets se matérialisèrent par un ensemble de redéfinitions des relations entre l’usager et le système de savoir porté par la bibliothèque, cela jusqu’à l’échelle de la station de travail.</p>

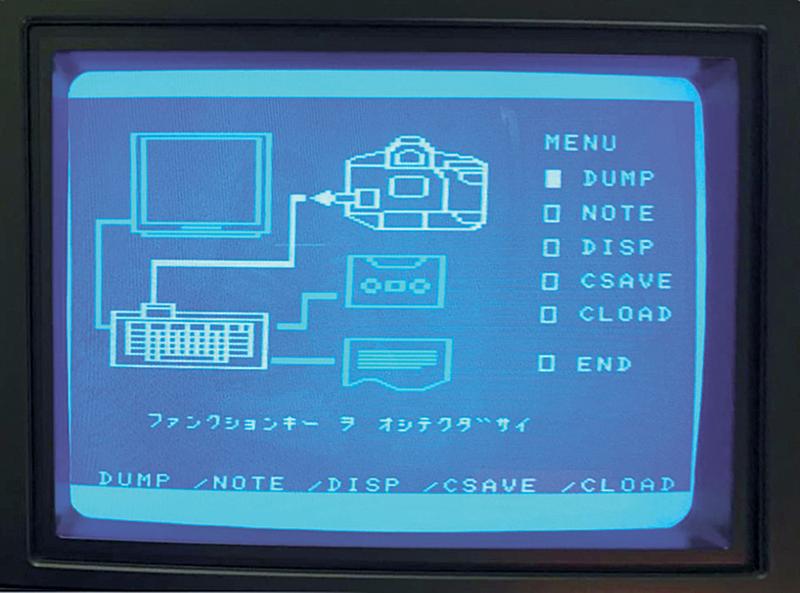

5. Chinon Info Back DB-010.

Guillaume Blanc (pp. 62-75) montre bien par ailleurs comment l’enthousiasme pour le microfilm et la neutralité prêtée à cette technique put aussi dissimuler de fortes dimensions idéologiques. À travers l’analyse de trois projets de documentation universelle formulés dans la France de l’après-guerre, l’auteur souligne la manière dont leurs promoteurs cherchèrent à conformer les dispositifs d’information envisagés aux structures idéologiques et à l’imaginaire national auxquels ils adhéraient. La réflexion sur les enjeux de pouvoir liés au contrôle des technologies de l’information est poursuivie dans l’essai de Monika Dommann sur l’histoire du photocopieur Xerox (pp. 76-89). Si le contrôle des dispositifs de reproduction et de diffusion de l’information avait longtemps été l’apanage de structures de pouvoir centralisées, l’apparition de Xerox marqua un tournant en introduisant, par ses coûts réduits et sa facilité d’utilisation, un moyen inédit de reproduction et de diffusion au service d’usagers indépendants de ces structures, notamment au sein des mouvements contestataires de l’après 68. De la fuite des archives du Pentagone réalisée à l’aide d’un Xerox en 1971 jusqu’à l’appropriation de cette machine par la gauche alternative zurichoise des années 1980, l’auteure met en lumière les usages subversifs de la photocopieuse et les tentatives toujours déjouées des administrations et des pouvoirs établis pour limiter la diffusion incontrôlée de l’information.

L’avènement de l’électronique dans le champ photographique ne fit que prolonger, en l’intensifiant, la façon avec laquelle le médium a pu agir comme une technique d’enregistrement et de traitement de l’information. Dès les années 1970, c’est-à-dire bien avant la commercialisation des premiers capteurs numériques, c’est précisément dans le champ des systèmes d’enregistrement automatisé de données écrites qu’apparurent les premières exploitations commerciales, suscitées par l’intérêt nouveau de l’industrie photographique pour l’électronique. Des accessoires comme le Data Back de Nikon, le Recordata d’Olympus, le Dataphot de Carl Zeiss ou l’Info Back de Chinon permettaient aux photographes de programmer l’impression automatisée de données techniques (dates, numéros d’identification ou autres) sous la forme de caractères alphanumériques sur la surface du négatif (fig. 5). Dès le début des années 1980, avec l’essor des ordinateurs personnels et le développement des mémoires informatiques, l’enregistrement de données ne fut plus circonscrit à la seule surface photochimique. Le Data Memory Back de Canon, par exemple, réduisit l’impression de caractères sur le négatif à un court identifiant de six chiffres, auquel renvoyaient les jeux de données enregistrées séparément sur mémoire vive (fig. 6 et 7). Depuis lors, photographier, c’est aussi générer massivement des données alphanumériques. À chaque ouverture du diaphragme, la captation optique est couplée à une multitude d’autres calculs visant à enrichir l’image d’informations. Or, comme le montre Estelle Blaschke (pp. 90-105), cette dimension « utilitaire » et « fonctionnelle » de la photographie renvoie à une logique capitaliste plus large d’exploitation automatisée des images, qu’elle soit explicitement commerciale, scientifique ou journalistique. En se focalisant sur la période de l’après-guerre, l’auteure montre que l’image photographique a joué un rôle majeur dans l’histoire du traitement de l’information, où elle a doublement agi comme support et comme objet de ce traitement. Si les informations qui accompagnent un cliché sont aujourd’hui aussi précieuses que l’image elle-même, cela doit beaucoup aux multiples travaux menés tout au long du XXe siècle pour imposer l’idée de l’image photographique comme donnée exploitable.

6. Canon Interface Unit TB.

7. Canon Interface Unit TB.

Collections

Outil de traitement de l’information, la photographie a donc aussi été l’objet de ce même traitement. Nombre de techniques et de standards ont en effet dû être mis au point pour gérer, organiser et tirer parti d’une production sans cesse croissante. On peut penser aux catalogues iconographiques, aux registres, aux fiches d’indexation et autres systèmes de classement, aux formats standardisés de métadonnées, aux banques d’images, aux algorithmes de gestion ainsi qu’aux divers instruments de juxtaposition de clichés comme les planches-contact ou les atlas, au sein desquels une photographie ne saurait exister individuellement. Souvent issus d’entreprises de production massive, le nombre, le flux et la mobilité accrus des images ont favorisé une approche quantitative et une accumulation foncièrement plurielle, moins assimilable à l’idée d’une collection que d’un vaste conglomérat d’objets visuels hétérogènes. La valeur de la photographie s’y trouve définie non pas tant par la somme des caractéristiques intrinsèques qui la constitueraient – la qualité esthétique, la rigueur documentaire – qu’en fonction des possibilités élargies d’exploitation dont elle peut faire l’objet. Penser la photographie dans ce cadre, cela implique dès lors de faire un pas en arrière, de permettre au regard de prendre de la distance et de se détacher du mode contemplatif pour adopter un point de vue surplombant son objet d’étude. L’image se fait alors tesselle au sein d’une vaste mosaïque dont le sens sera d’autant plus précis que ses éléments seront nombreux et soigneusement agencés.Dans les institutions, l’intégration de ce que nous proposons d’appeler ici les « images augmentées » n’a pu se faire qu’au prix d’un bouleversement profond des modes de fonctionnement. Trois essais dans la rubrique Collections reviennent sur l’histoire et les enjeux théoriques, professionnels et économiques liés à ces changements dans trois espaces distincts – la bibliothèque, le musée, l’agence de presse –, couvrant ainsi une partie importante du champ institutionnel touché par ces pratiques.

Du côté des bibliothèques, l’article de Dominique Versavel (pp. 112-123), conservatrice de la photographie à la Bibliothèque nationale de France, retrace les principales étapes dans l’adoption progressive de nouvelles technologies de l’information pour le traitement des pièces de son département, du catalogue sur fiches à la numérisation, et met ainsi en lumière les « interférences » causées par chacune de ces étapes dans les politiques de l’institution. Ce fut également le cas lors de la création d’une photothèque au musée de l’Homme en 1938. Or, comme le souligne Anaïs Mauuarin (pp. 124-135), les choix de traitement opérés lors de la phase d’organisation des collections photographiques du musée prirent ouvertement en compte les enjeux de diffusion et les attentes commerciales que ses promoteurs nourrissaient face à un marché des images alors en pleine expansion. Si l’adoption de nouvelles technologies a pu ainsi être souvent motivée par un enjeu économique, dans le champ des agences photographiques, le contraire est paradoxalement aussi valable. Comme le montre Clara Bouveresse dans son étude sur l’histoire des numérisations successives de l’agence Magnum (pp. 136-145), les résistances provoquées par celles-ci au sein de l’équipe visaient précisément à préserver un modèle économique fondé non pas sur l’accessibilité accrue et la diffusion libre des ressources, mais au contraire sur la rareté des tirages, dont la valeur était d’autant plus élevée que leur disponibilité restait limitée.</p>

En définitive, ce sont les pratiques les plus actuelles que les articles rassemblés dans ce dossier permettent de reconsidérer. Souvent peu visible, voire explicitement cachée, la part informationnelle de la photographie tend en réalité à occuper une place de plus en plus importante dans notre culture visuelle. En cerner les contours et en explorer l’histoire permet de se doter d’outils précieux pour mieux appréhender notre rapport quotidien aux images. Pour renforcer les allers-retours entre enquêtes historiques et regards contemporains, nous avons invité deux personnalités, l’une provenant du monde de l’art, l’autre de celui de l’informatique, à réagir aux questions soulevées par la thématique de ce dossier. La première intervention est celle de l’artiste Jeff Guess (pp. 36-47), qui a choisi la forme de l’essai pour prolonger la réflexion sur la fragilité inhérente à la place du visuel dans la société de l’information actuelle. L’auteur propose de considérer le visuel comme un lieu privilégié de la rencontre animal-humain-machine à travers l’exploration libre de trois formes d’apprentissage des signes et du langage. Cette primauté du visuel est aussi au centre de la deuxième intervention, qui se présente sous la forme d’une conversation avec l’ingénieure et spécialiste de la vision par ordinateur Sabine Süsstrunk (pp. 106-110). De la « réalité de terrain » à la « vallée de l’étrange », elle nous embarque dans l’exploration d’un champ, celui de la photographie computationnelle, dont les résultats obtenus au cours de la dernière décennie sont à la fois enthousiasmants et troublants. Enthousiasmants, car les réseaux de neurones artificiels arrivent aujourd’hui à identifier des images avec une précision inouïe. Mais aussi troublants, comme le souligne la chercheuse, car « nous ne savons presque rien » de leur véritable façon de fonctionner dans les couches les plus profondes. C’est dire combien, en fin de compte, la photographie résiste toujours au traitement purement factuel de l’information pour impliquer, selon Paul Vanderbilt, conservateur de la Library of Congress, « l’inconnu, le provisoire, l’inexpliqué, le mystérieux, l’expérimental, l’irrationnel16 ».

Référence : Estelle Blaschke, Davide Nerini, « Introduction. Vers l'image augmentée », Transbordeur. Photographie histoire société, no 3, 2019, pp. 6-16.