Les technologies du numérique sont volontiers associées à un « déferlement » d’images, transmises instantanément et partagées à large échelle sur les réseaux sociaux ; la nécessité de leur stockage a confronté les bibliothèques, les banques d’images, les agences photo à de nouveaux défis quant au classement et à l’accessibilité de ces masses documentaires. Or, toutes ces questions qui nous semblent découler du numérique se sont en réalité déjà posées par le passé et ont trouvé au fil du temps d’autres réponses techniques.

La rapidité des flux était ainsi déjà au centre des préoccupations des éditeurs de presse dans les années 1920 et leur accélération a contribué à de profonds changements dans les représentations du temps et de l’espace, quand une image produite à Paris pouvait être vue à New York l’instant suivant. L’augmentation de la masse d’informations visuelles a quant à elle engendré l’utopie d’une connaissance exhaustive sur le monde, dont les témoignages seraient rangés en des lieux accessibles à tout moment. C’était le cas, dès le tournant du XXe siècle, des « musées de photographies documentaires » qui ont fait l’objet du dossier du premier numéro de Transbordeur. L’une des solutions apportées plus tard pour rendre ces documents facilement accessibles aux usagers fut l’invention du microfilm et de la microfiche, qui imposa à son tour des restructurations nombreuses d’ordre bibliothéconomique et affecta les bibliothèques jusque dans leur architecture. Quant au classement de ce matériau visuel, il pose un problème qui a traversé les décennies : celui d’associer aux documents des mots clés ou des informations codées permettant de les retrouver aisément. Pour organiser leurs fonds, agences photo et autres institutions ont mis au point chacune leur méthode, recourant à l’annotation manuelle. Ces méthodes ont été transformées lorsqu’avec l’essor de l’électronique, bien avant l’usage des appareils photo numériques, apparurent les premiers catalogues informatisés. Qu’en est-il aujourd’hui, quand le nombre d’images devient, plus encore que jadis, non maîtrisable par des humains ? Le rêve d’une lecture automatique et d’une indexation opérée par la machine n’est plus très loin.

Ce qui a changé avec le numérique ne se laisse pas facilement définir. Est-ce la possibilité d’une agrégation de plusieurs types d’informations – texte et image – sur un même fichier ? C’est oublier que le problème de l’intégration du texte et de l’image est apparu bien plus tôt, dès la fin du XIXe siècle, avec les banques d’images d’histoire de l’art notamment. S’agit-il des algorithmes qui peuvent désormais « lire » les images ? Certes, mais l’utopie d’une lecture non humaine du visuel est plus ancienne et renvoie à des expérimentations scientifiques d’apprentissage automatisé menées dans les années 1960 et 1970. Est-ce la modalité d’accès aux documents visuels, facilitée par les moteurs de recherche et les méta-moteurs qui interconnectent les catalogues ? Sans doute, mais l’intelligence relationnelle des moteurs de recherche n’a été rendue possible que grâce à l’uniformisation de ces catalogues, qui remonte aux années 1930. Les médias ont une histoire que la fascination pour la technologie tend parfois à négliger. Cette histoire abandonne sur le bord du chemin des inventions inachevées, des réponses incomplètes qui en disent parfois plus long que les idées victorieuses. Il faut savoir se détourner de la mythologie du « tournant numérique » pour comprendre la lente élaboration de l’image augmentée.

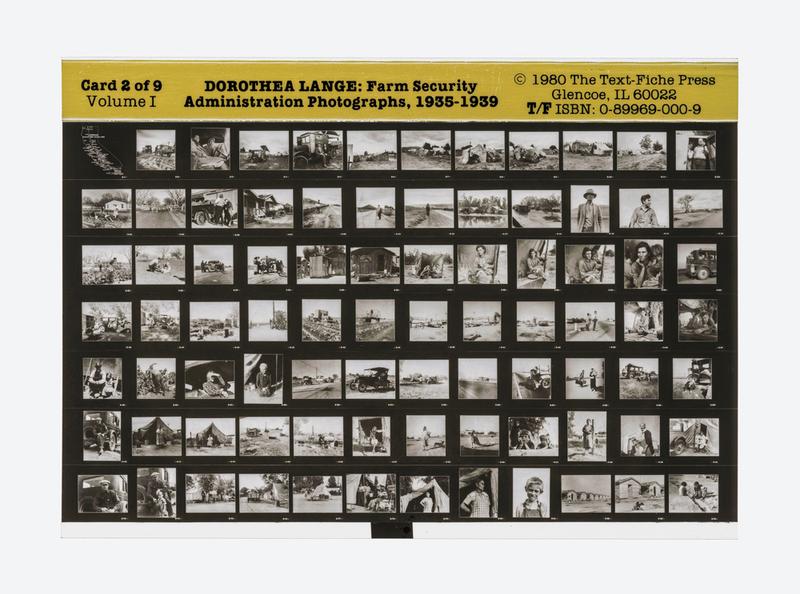

Dorothea Lange, Farm Security Administration Photographs, 1935-1939, vol. 1, no 2, Glencoe, Text-Fiche Press, 1980.

Cette microfiche a été montrée dans l’exposition Dorothea Lange. Politiques du visible (Paris, Jeu de Paume, 2018).

Référence : La rédaction, « Éditorial », Transbordeur. Photographie histoire société, no 3, 2019, pp. 2-3.